python爬虫智能翻页批量下载文件

文章目录

- 一、思路是什么?

- 二、使用步骤

- 1.引入库

- 2.解析初始页面

- 3.获得投资关系的分类名称和url地址

- 4.每个列表信息,保存一个文件夹

- 5.对列表的每个项目链接进行解析,拿到尾页

- 7,让文件名和文件链接处理为列表,保存后下载

一、思路是什么?

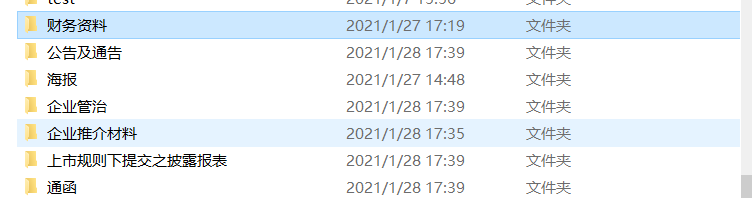

以京客隆为例,批量下载文件,如财务资料,他的每一份报告都是一份pdf格式的文档。以此页面为目标,下载他每个分类的文件

整体思路如下

二、使用步骤

1.引入库

代码如下(示例):

import requests

import pandas as pd

from lxml import etree

import re

import os

2.解析初始页面

代码如下(示例):

baseUrl ='http://www.jkl.com.cn/cn/invest.aspx' # 爬取页面的数据

heade ={

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.92 Safari/537.36'

}

res =requests.get(url=baseUrl,headers=heade).text

# print(res.text)

html = etree.HTML(res)

res =requests.get(url=baseUrl,headers=heade).text # 设置变量接受 基础页的响应数据

# print(res.text)

html = etree.HTML(res)

3.获得投资关系的分类名称和url地址

代码如下(示例):

data_name = html.xpath('//div[@class="infoLis"]//a/text()') # 投资者列表的名字

data_link = html.xpath('//div[@class="infoLis"]//@href') # 全部列表的链接

name = [data_name.strip() for data_name in data_name] # 通过for循环去掉空字符

link = ['http://www.jkl.com.cn/cn/'+ data_link for data_link in data_link] # 拼接字符串

# 合并为字典,方便保存文件

file = dict(zip(name,link))

4.每个列表信息,保存一个文件夹

代码如下(示例):

for name,link in file.items():

name=name.replace('/','.')

name=name.replace('...','报表')

# 上面的把文件名带特许字符的 强制转换为我们想要的文本类型

path = 'E:/'+ name

if not os.path.exists(path):

os.mkdir(path)

#建立储存位置

5.对列表的每个项目链接进行解析,拿到尾页

代码如下(示例):

res_list = requests.get(url = link, headers = heade).text

list_html = etree.HTML(res_list)

# print(html_erJi) 解析每个分类的链接

weiYe = list_html.xpath('//a[text()="尾页"]/@href')

# print(html_weiye)

# 拿到尾页信息

if weiYe !=[]:

# 正则提取尾页信息

get_weiYe =re.search("(\d+)'\)",html_weiye[0])

get_yeMa = get_html_weiYe.group(1)

else:

get_yeMa=1

# print(get_html_yeMa) 看看是不是提取成功

## 6.获取每个列表信息下的 文件名和文件链接

代码如下(示例):

for get_yeMa in range(1,int(get_yeMa)+1): # 翻页

yaMa= {

'__EVENTTARGET': 'AspNetPager1',

'__EVENTARGUMENT': get_yeMa

}

get_lei_html = requests.get(url = link, headers = heade, params = yaMa).text

res3 =etree.HTML(get_lei_html)

# print(res3)

pdf_name = res3.xpath('//div[@class="newsLis"]//li/a/text()')

# print(pdf_name)

pdf_url = res3.xpath('//div[@class="newsLis"]//li//@href')

7,让文件名和文件链接处理为列表,保存后下载

代码如下(示例):

pdf_names = [pdf_name.strip() for pdf_name in pdf_name]

# print(pdf_names)

if all(pdf_url):

pdf_urls = ['http://www.jkl.com.cn'+pdf_url for pdf_url in pdf_url]

# print(pdf_url)

pdf_data=dict(zip(pdf_names,pdf_urls)) # pdf地址和名字整合为字典

for pdfName,pdfUrl in pdf_data.items():

pdfName =pdfName.replace('/','.')

res_pdf= requests.get(url =pdfUrl,headers=heade).content

houZui = pdfUrl.split('.')[-1]

pdf_pash = path + '/' + pdfName + '.'+ houZui #

# print(pdf_pash)

with open(pdf_pash,'wb') as f:

f.write(res_pdf)

print(pdfName,'下载成功')

#全部代码

代码如下(示例):

import requests

import pandas as pd

from lxml import etree

import re

import os

baseUrl ='http://www.jkl.com.cn/cn/invest.aspx' # 爬取页面的数据

heade ={

'user-agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.92 Safari/537.36'

}

# 1 获取分类模块链接及文件名称

res =requests.get(url=baseUrl,headers=heade).text # 设置变量接受 基础页的响应数据

# print(res.text)

html = etree.HTML(res)

data_name = html.xpath('//div[@class="infoLis"]//a/text()') # 投资者列表的名字

data_link = html.xpath('//div[@class="infoLis"]//@href') # 全部列表的链接

name = [data_name.strip() for data_name in data_name] # 通过for循环去掉空字符

link = ['http://www.jkl.com.cn/cn/'+ data_link for data_link in data_link] # 拼接拿到列表的各个链接地址

# 合并为字典,方便保存文件

file = dict(zip(name,link))

for name,link in file.items():

name=name.replace('/','.')

name=name.replace('...','报表')

# 上面的把文件名带特许字符的 强制转换为我们想要的文本类型

path = 'E:/'+ name

if not os.path.exists(path):

os.mkdir(path)

#建立储存位置

res_list_url = requests.get(url = link, headers = heade).text

list_url_html = etree.HTML(res_list_url)

# print(html_erJi) 解析每个分类的链接

weiYe = list_url_html.xpath('//a[text()="尾页"]/@href')

# print(html_weiye)

# 拿到尾页信息

if weiYe !=[]:

# 正则提取尾页页数

get_weiYe =re.search("(\d+)'\)",weiYe[0])

get_yeMa = get_weiYe.group(1)

else:

get_yeMa=1

# print(get_html_yeMa) 看看是不是提取成功

for get_yeMa in range(1,int(get_yeMa)+1): # 翻页

yaMa= {

'__EVENTTARGET': 'AspNetPager1',

'__EVENTARGUMENT': get_yeMa

}

get_erJi_html = requests.get(url = link, headers = heade, params = yaMa).text

res3 =etree.HTML(get_erJi_html)

# print(res3)

pdf_name = res3.xpath('//div[@class="newsLis"]//li/a/text()')

# print(pdf_name)

pdf_url = res3.xpath('//div[@class="newsLis"]//li//@href')

# print(pdf_url)

pdf_names = [pdf_name.strip() for pdf_name in pdf_name]

# print(pdf_names)

""" 处理文件的空数据问题"""

if all(pdf_url):

pdf_urls = ['http://www.jkl.com.cn'+pdf_url for pdf_url in pdf_url]

# print(pdf_url)

data2=dict(zip(pdf_names,pdf_urls))

for s,n in data2.items():

s =s.replace('/','.')

res4 = requests.get(url=n,headers=heade).content

houzui = n.split('.')[-1]

pdf_pash = path + '/' + s + '.'+houzui

# print(pdf_pash)

with open(pdf_pash,'wb') as f:

f.write(res4)

print(s,'下载成功')

下载的文件

5228

5228

暂无认证

暂无认证

盼盼编程: 先占个坑,慢慢看

不正经的kimol君: 学起来,头秃的那种~

盼盼编程: 先占个坑,慢慢看。要是能受到大佬的回访那就太好了!

air1100: 好!

兴趣使然的程序猿: 点赞支持一下,原创不容易,深有体会